让我带您通过我的个人探索,清洁和最终从原始数据中发掘出宝贵的见解的经验。这标志着我的第二个可视化项目;首先涉及分析2015年英国道路安全数据,利用Matplotlib和Seaborn创建视觉效果。

作为入门者,我想体验到Tableau项目的现实生活数据的感觉,并且我想要一个我了解的数据集。搜寻互联网后,我认为这是正确的数据集。

与原始数据相遇

我在数据中下载了来自我们世界的大数据集,并在Excel中打开了它,以预览我将使用的内容。需要将数据分为两个子集:covidtests.csv,持有原始的covid-19测试数据和coviddeaths.csv,其中包含原始的covid-19死亡数据。但是由于某些不一致之处,我后来删除了covidtests.csv文件,而在我的分析中没有使用它。

盯着屏幕上装满了数字和标签行上的行。这正是我的旅程开始的地方。我制定数据感的系统方法通常涉及使用Python中的Pandas库清洁,使用PostgreSQL进行分析,并使用Tableau Tableau可视化数据。

了解数据

第一步是了解数据的问题。 coviddeaths.csv文件具有与我的分析范围无关的某些功能。我首先将数据简化为仅包括重要列,即:

- iso_code :这代表“国际标准化组织”代码。这是一个三个字母的代码,可以唯一地标识一个国家或地区。

- 大陆:这表明该国或领土所在的大陆。

- 位置:这是指在数据集中报告的国家的名称。

- date :此列表示记录COVID-19数据的日期。

- 人口:此值表示该国或领土的总人口。

- total_cases :这代表了确认的COVID-19案例的累积数量,直到特定位置的给定日期。

- new_cases :这显示了给定日期报告的新确认的Covid-19案件的数量。

- total_deaths :这表明在特定位置的给定日期之前,已确认的COVID-19的死亡总数。

- new_deaths :这代表给定日期新报告的与19 covid-19的死亡的数量。

使用国家列以字母顺序排列数据集。

数据清洁的艺术

不一致,缺失值和离群值在数据集中猖ramp,因此是数据清洁的原因。执行数据探索以了解数据集的基本结构和功能之后,我用零替换了数字列中的空值,并将数据类型更改为integer。

continent列中也缺少值,因此我使用Google执行了一些验证,因此有必要放下这些行,我进行了这些行。这是我在将数据导出到CSV文件之前所采取的两个主要步骤(coviddeaths.csv)。

揭示数据的秘密

是时候将基础模式拼凑在一起了。我在PostgreSQL中创建了一个与CSV文件中的列相同的列中的coviddeaths表,然后将数据从文件复制到SQL表。我要做的第一件事是在81,060行表上创建一个索引,从而使汇总,计算和查看数据子集更快。

为了进行可视化,我需要一个表格以在大陆规模上查看事物。一张表显示了每个大陆人口,每大洲的共同19例案例总数,以及每大陆的共同死亡人数。我使用通用表表达式创建了表。

可视化看不见的

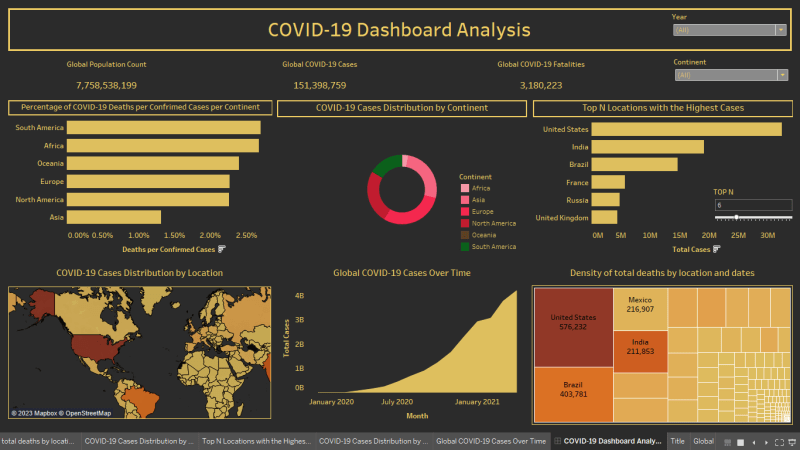

可视化的力量不能被夸大。我会自己选择“交互式仪表板”中的调整按钮,而不必阅读页面尝试在数据中找到模式。我使用条形图,饼图,热图等工作。当我创建这些视觉效果时,数据开始向我揭示其见解。在某些国家的Covid -19案件中的激增,人口与总案件之间的相关性 - 这些是视觉效果的信息。

“啊哈!”片刻

是我第一次尝试创建仪表板的尝试“啊哈!”时刻到了。在这一点上,我知道如何安排工作表,使用哪些过滤器。我刚刚解锁了宝藏的宝贵信息。

关键观察

这是我遇到的一些发现:

该数据代表了截至2021年4月30日的COVID-19大流行的全球状况。

- 联合19案的全球数量为151,398,759,死亡人数为3,180,223。

- 美国的案件数量最多(32,346,970)和死亡人数(576,232)。

- 印度在案件方面是第二高的(19,164,969),在死亡方面是第三高的人(211,853)。

- 在案件(14,659,011)方面,巴西是第三高的人,在死亡方面是第二高的(403,781)。

- 一日报道的新Covid-19案件中最多的案件在2021年4月30日在印度401,993例。

- 南非的死亡率最高,为2.70%。

访问代码和文件

如果您有兴趣探索该项目中使用的代码和文件,则可以在我的GitHub repository上找到所有内容。存储库包含在分析过程中使用的Python脚本,SQL查询和数据集文件。

结论

每个数据探索都是一个独特的旅程,充满了高潮,挫败感和启示。有了正确的工具和思维方式,任何复杂的数据都值得探索。这次探险教会了我不仅教会了数据分析技能。它教会我逐步解决问题,耐心,毅力以及我们可以使用数据的程度。因此,下次您面对一个似乎令人生畏的数据集时,请记住 - 这不仅是数据,而且还在等待。